ChatGPT? Creació d'imatges? Traducció de textos? Automatització d'assignació d'hipoteques o ajudes socials? Què està passant amb la intel·ligència artificial? Què són totes aquestes noves eines que s'estan incorporant en el nostre dia a dia? Recupera les idees que han compartit Maria Vanrell i Carlos Castillo a la primera sessió del cicle «IA, Drets i Democràcia»: «WTF, intel·ligència artificial? Riscos i potències».

Que l'expressió complexa «intel·ligència artificial» (IA) sigui la paraula de l'any 2022 és simptomàtic de l'atenció mediàtica que hi ha sobre aquesta tecnologia. Malgrat fer 50 anys que s'aplica per a fer més senzills processos complexos, és ara quan ha aconseguit guanyar espai en la quotidianitat de les persones i presència en mitjans de comunicació i indústria. Això també ha provocat que es generin polèmiques respecte al seu mal ús.

És per això que la Unió Europea ha començat a crear regulacions per a un ús ètic d'aquestes eines, que han arribat per a quedar-se. El 2022 es va plantejar la implementació de normatives que generin un ús responsable de la IA, que hauran de ser aplicades i estar vigents en tots els països membres de la Unió Europea.

Si bé és necessari establir des del marc jurídic lleis per a protegir la ciutadania de futures i possibles amenaces de la IA i els seus avanços engegantits, també és de summa importància l'alfabetització de la societat en aquesta matèria. En aquesta línia, el Canòdrom – Ateneu d’Innovació Digital i Democràtica ha iniciat el cicle de conferències «IA, Drets i Democràcia», on s'analitzen aquestes eines des d'una perspectiva de drets i democràtica. En la primera sessió, «WTF, intel·ligència artificial? Riscos i potències», les investigadores i expertes en intel·ligència artificial Maria Vanrell i Carlos Castillo han proposat des del seu coneixement i experiència un aterratge pràctic a la IA.

Escolta el Pòdcast a la XRCB de Ràdio Canòdrom

Xarxes neuronals que s'entrenen a través d'exemples

Explica Maria Vanrell, catedràtica a la UAB i coordinadora del màster interuniversitari de Visió per Computador, que la base de la intel·ligència artificial està inspirada en el cervell humà. Es tracta de xarxes neuronals profundes que funcionen, aprenen i s'entrenen a través d'exemples: fotografies, textos i fins i tot la seva experiència sobre els errors comesos en el procés de reconeixement i assignació de categories.

Per a comprendre el vast món de la intel·ligència artificial primer hem d'entendre què és un «algortime». Vanrell estableix que és un conjunt de regles programades en forma de funció que estan fetes per a resoldre un problema. Una vegada establerta la base, ens endinsem en el seu desenvolupament. Estiguin presents o no els biaixos en la funció, aquests poden anar prenent força per les dades que es processen.

Els sistemes de IA són una eina que ha agilitzat la vida de les persones, però a poc a poc ha començat a sorgir una alerta per la discriminació automatitzada que presenten els algorismes. Maria Vanrell aclareix que un biaix és una predisposició socialment construïda, i que el més natural és que els algorismes presentin biaixos en la seva programació. Vanrell considera que aquestes qüestions i dubtes poden causar temor i incertesa en la societat, que sent una amenaça que no pot palpar.

Com s'estableixen els biaixos en una cosa a priori tan objectiva i matemàtica com un algorisme? Estem envoltats de tecnologies que contenen algorismes, sigui en el mòbil o en el caixer automàtic. Actualment, l'ús de tecnologies digitals i plataformes genera una ingent quantitat d'informació: dades bancàries, domicili, gènere, gustos, preferències o comportament. A partir de recollir aquestes dades, es generen categories en les quals la persona és assignada. Així, quan se sol·liciti una hipoteca, una ajuda social o quan s'apliqui a una oferta laboral, és més que probable rebis un tipus de resposta o una altra.

Ara bé, la detecció d'aquests biaixos és complexa a causa de la quantitat de neurones que són presents en aquesta mena de xarxes. Per a resoldre aquesta qüestió, Carlos Castillo, professor en la UPF on dirigeix el grup de Ciència Web i Computació Social, entra en l'equació.

Detectar biaixos en l'entorn laboral a través d'estadístiques

Encara que és un treball complicat, és possible detectar els biaixos a través de mètodes estadístics. Sovint s'intenta determinar les desigualtats controlades per algunes variables que determinin la discriminació, explica Carlos Castillo.

Subratlla que «cada vegada que creguem un algorisme basat en dades d'entrenament, en aquestes dades d'entrenament hi ha petits i a vegades grans biaixos que el sistema tendeix a amplificar». Gràcies a l'aplicació de mètodes estadístics, en particular l'«auditoria algorítmica», és possible analitzar si un algorisme funciona de manera correcta i alhora possibilita conèixer si existeix algun tipus de biaix en el sistema.

Un dels àmbits on es produeixen més discriminacions és el sector laboral. Castillo cita un estudi que va realitzar el seu grup el 2017, en el qual s'observa com els algorismes dels portals laborals tendeixen a exagerar diferències de gènere preexistents en professions com a economista, analista o editor. Els sistemes d'ordenament no visibilitzen a dones professionals d'acord amb la realitat. Si s'observen els deu primers resultats en un portal d'ocupació, només apareix una dona, per la qual cosa fa l'efecte que només existeix un 10% de dones en aquesta professió.

Per a reconduir situacions de discriminació en l'entorn laboral, en 2022 el Govern de l'estat espanyol va presentar una guia pràctica per a l'ús de la IA i les seves eines en el sector laboral. En aquesta guia s'exposen les obligacions que han d'assumir les empreses al moment de realitzar contractacions de personal, per a garantir el dret vital de la no discriminació.

La tecnologia, els seus usos i possibles aplicacions són eines que haurien de ser emprades a favor nostre, però en algun punt poden ser mal utilitzades i aplicades de manera negativa en la societat. És per aquesta raó que ha d'existir una regulació, una auditoria constant, amb la finalitat de vetllar pels drets de les persones, les seves dades personals i el seu futur.

Intel·ligència artificial, polítiques públiques i discriminacions

Queden molts reptes pendents, un dels quals és: com construir una intel·ligència artificial de governança pública, auditable i en pro del bé comú? Com obrir i fer comú alguna cosa que es nodreix d'ingents quantitats de dades i sabers acumulats al llarg de la història de la humanitat, però que tendeix a ser governada per un petit grup d'empreses tecnològiques?

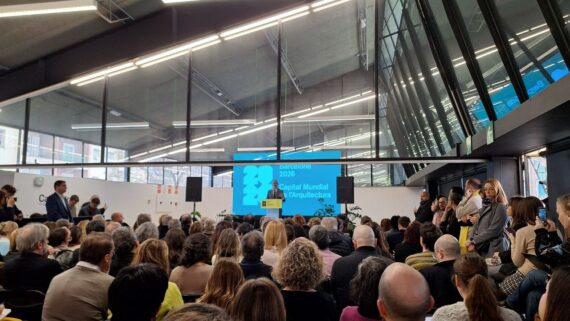

El 20 d'abril contínua el cicle «IA, Drets i Democràcia» amb la sessió «Intel·ligència artificial, polítiques públiques i discriminacions» amb Paula Boet (Ajuntament de Barcelona), Karlos Castilla (Institut de Drets Humans de Catalunya) i Paula Guerra (Algorace). Les tres expertes posen sobre la taula en què estan treballant per a corregir les discriminacions automatitzades dels algorismes en polítiques públiques.