¿Podemos soñar con sistemas de IA de gobernanza pública sin sesgos de género, racistas o clasistas? ¿Qué rol tiene que tener la ciudadanía y el tercer sector? Recupera las ideas que han compartido Karlos Castilla, Paula Guerra Cáceres y Paula Boet a la segunda sesión del ciclo «Inteligencia artificial, Derechos y Democracia: IA, políticas públicas y discriminaciones».

Hoy en día, un total de 27565 personas han firmado la carta abierta «Pause Giant AI Experimentos: An Open Letter» la cual propone una moratoria de al menos seis meses en el desarrollo de la inteligencia artificial. Los motivos que avalan la propuesta se basan en el ritmo acelerado de varias inteligencias artificiales, como ChatGPT. La IA presenta riesgos, amenazas y vulnerabilidades significativas para nuestros derechos y libertades, así para la misma democracia, pero también potencialidades: nos encontramos ante un escenario incierto donde las regulaciones por parte del sector público son más importantes que nunca.

Hablar hoy en día de inteligencia artificial y el adelanto acelerado que presenta, forma ya parte de la sociedad. ¿Pero qué sucede cuando una tecnología tan innovadora, que tendría que ayudarnos a todo el mundo por igual, presenta sesgos que generan discriminación o racismo? El año 2021, un estudio desarrollado por la IE University reveló que un 64,1% de las personas europeas creen que la tecnología está reforzando la democracia.

En esta línea, la segunda sesión del ciclo de conferencias «IA, Derechos y Democracia» del Canòdrom – Ateneo de Innovación Democrática de Barcelona, las expertas en ética, política y tecnología Paula Guerra Cáceres, Karlos Castilla y Paula Boet hablan sobre como construir una inteligencia artificial de gobernanza pública, auditable y en pro del bien común. La falta de formación y divulgación de los algoritmos de esta tecnología en la sociedad civil plantea un debate: cómo las personas se relacionan con la IA, ¿qué derechos adquieren y cuáles ponen en riesgo?

Los intereses políticos y las discriminaciones inherentes a los algoritmos

El informe «Cuatro ángulos de análisis de la igualdad y la no discriminación en la inteligencia artificial (2022)» del Instituto de Derechos Humanos de Cataluña y la Open Society Foundation, afirma que China, los Estados Unidos y Japón, representan el 78% de todas las solicitudes de patentes de inteligencia artificial en el mundo. El África y la América Latina son los países con los niveles más bajos.

El documento propone un análisis de los efectos positivos y negativos de la IA respecto a la igualdad y no discriminación a partir de cuatro ángulos fundamentales que responden a las preguntas: dónde, quien, para qué y como se desarrolla esta tecnología. En esta línea, Karlos Castilla, investigador en el Instituto de Derechos Humanos de Cataluña, expuso el caso de una charla sobre IA donde el mensaje estaba presente en las imágenes: asistieron una mayoría de hombres blancos y una minoría de mujeres. Y es que los estereotipos de género y las discriminaciones no solo se codifican en los sistemas tecnológicos. El experto indicó que este tipo de lugares serían espacios que generan discriminaciones.

Algoritmos que determinan si una denuncia es falsa o prevén el nivel de probabilidad de reincidencia de un crimen

No solo las instituciones y administraciones públicas hablan de los desafíos de la gobernanza digital y la elección de los sistemas de inteligencia artificial en la administración pública. También lo están haciendo organizaciones de la sociedad civil que buscan dar a conocer y reflexionar colectivamente como están diseñados estos algoritmos y qué soluciones se pueden aportar desde la perspectiva de defensa de derechos en esta era digital.

En este sentido, Paula Guerra Cáceres, de la entidad Algorace, que se dedica a analizar e investigar el racismo estructural y sus consecuencias en el ámbito digital, presentó el informe «Una introducción a la IA y la discriminación algorítmica para MMSS» (2022) que «surge con la idea de acercar la temática de la IA y el impacto que tiene en personas y colectivos racializados», afirmó Guerra. Los nuevos procesos de transformación digital relacionados con la IA, así como las políticas públicas que aplican esta tecnología, son regulados ignorando la voz de la sociedad civil organizada.

Uno de estos casos es VeriPol, una tecnología basada en inteligencia artificial que usa el procesamiento del lenguaje natural para analizar denuncias policiales. Predice si la denuncia es falsa o no en función de los detalles que dé la persona denunciando y la morfosintaxi que emplee al hablar. Este algoritmo ha sido fuertemente criticado por el hecho que fue creado con una base de datos muy limitada, bajo la supervisión de un solo policía, lo cual no garantiza una aplicación justa que proteja los derechos de quienes denuncia. Otro ejemplo se encuentra dentro del sistema penitenciario del estado español, el cual predice el nivel de probabilidad de reincidencia de un crimen, teniendo como variables barrios, grupos demográficos e incluso la localidad de donde proviene la persona recluida, lo cual refuerza el sistema discriminatorio y punitivo de la justicia.

Mecanismos para regular la IA

Este tipo de casos también se observan en otros países del territorio europeo. En Países Bajos entró en funcionamiento el sistema SIRIO, el cual detecta y revela posibles fraudes al Sistema de bienestar, Hacienda o Seguridad Social mediante una evaluación de datos de las familias beneficiarias de ayudas estatales. Este algoritmo lanzó como resultado a las «posibles familias defraudadoras» del Estado, familias trabajadoras y de clase mediana, fomentando la discriminación y segregación, además de una invasión a su privacidad. Un caso similar pasa en el estado español, con BOSCO, un software desarrollado por orden del Gobierno que las eléctricas utilizan para decidir quién es beneficiario del denominado bono social eléctrico.

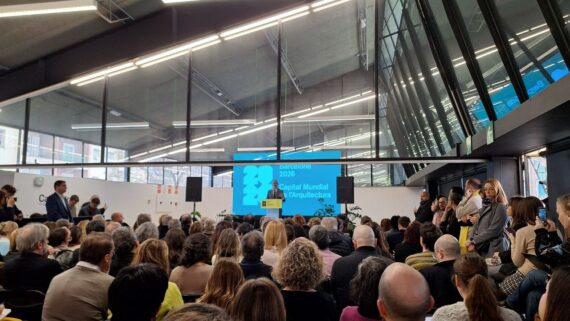

En este sentido, para combatir desde la raíz la discriminación, el racismo y machismo que implica el uso de la IA en nuestras vidas, el Ayuntamiento de Barcelona ha creado el protocolo «Definición de metodologías de trabajo y protocolos para la implementación de sistemas algorítmicos» (2023). Según Paula Boet, del Comisionado de Innovación Digital - Fundación BIT Hábitat del Ayuntamiento de Barcelona, «es un documento pionero respecto a la regulación y la gobernanza de los sistemas algorítmicos en el ámbito local».

El protocolo se basa en la propuesta de regulación europea sobre la inteligencia artificial y define, paso a paso, los mecanismos de garantía y salvaguardia de derechos que se tienen que introducir en cada momento de la implementación de un sistema de inteligencia artificial por parte de los entes locales.

Inteligencia artificial, comunicación y periodismo

La IA ya se ha introducido sistemáticamente en la comunicación, y de muchas formas diferentes. En privado, la conocemos por los asistentes de voz de los smartphones, por ejemplo, SIRIO a los dispositivos móviles o Alexa a los hogares. En el ámbito de la comunicación, ha abierto una ventana de oportunidades, con una rendija suficiente oscura de retos, como es el caso de ChatGPT o software que generan imágenes automáticas de creación digital. Estas nuevas herramientas, facilitan el trabajo de los periodistas y comunicadoras o las sustituyen? ¿Donde está la frontera?

El 18 de mayo continúa el ciclo «IA, Derechos y Democracia» con la sesión «IA, comunicación y periodismo» con Patrícia Ventura (investigadora en ética, inteligencia artificial y comunicación), Judith Membrives (técnica de digitalización de Lafede.cat), Carles Planas Bou (periodista especializado en tecnología en El Periódico) y Enric Borràs (subdirector del Diario Ahora). Las cuatro expertas pondrán sobre la mesa que supone el uso y la normalización de la inteligencia artificial por el sector de la información y la comunicación.